机器学习技术大评比第一次结果出炉MLPerf新测试标準让各家自己秀强项

机器学习基準测试套件MLPerf于推出7个月后,根据第一轮由Nvidia、谷歌和英特尔提交的资料,发布了第一次的结果。MLPerf的结果测量了主要机器学习硬体平台的速度,包括Google的TPU、英特尔CPU和Nvidia GPU,同时结果也提供了诸如TensorFlow、PyTorch和MXNet等机器学习软体框架速度的了解。

MLPerf为一个新兴的基準测试套件,提供了衡量云端供应商和内部硬体平台的效能的方法,其训练几準由资料集和品质目标定义,而且同时还为每一个基準使用的特定模型提供了参照实作,虽然MLPerf v0.5包含7个基準测试,但实际上只有5个类别,分别是图像分类、物体侦测、翻译、推荐和增强学习。

测量基準是量测将模型训练到达目标品质所需要的时间,然后将MLPerf时间结果标準化,在单个Nvidia Pascal P100 GPU上执行的未最佳化的参照实作,官方提到,未来的MLPerf基準测试也将包括推理。 MLPerf量测基準分为两部分封闭与开放,封闭的比较主要测试机器学习硬体和框架,需要使用相同的模型以及Optimizer,而开放则可以使用任意的模型。在第一轮的比较上,各家都选择先在封闭基準测试较量。

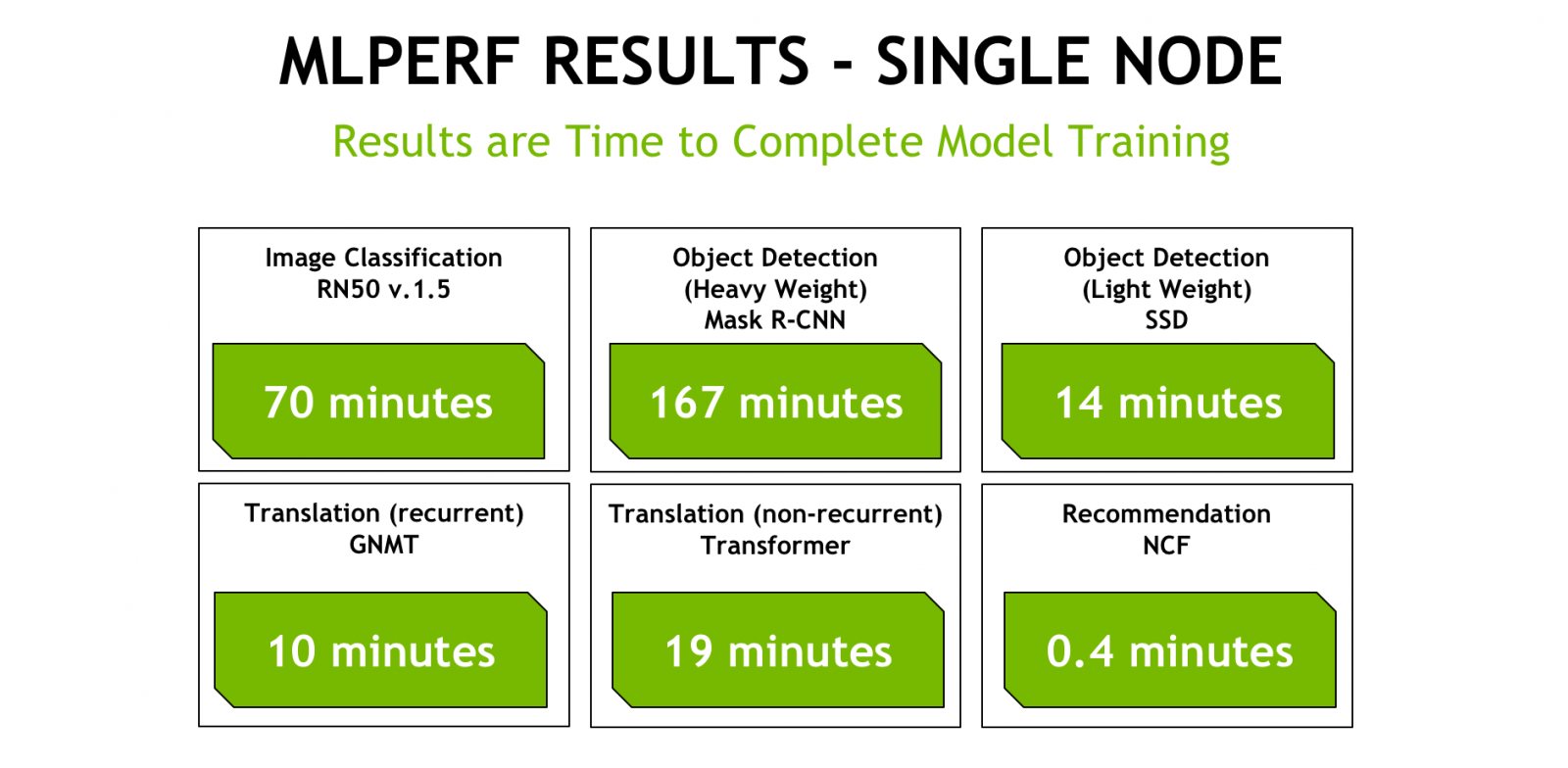

Nvidia在部落格发布了自家测试结果,包括单节点测试以及规模测试,并且提到,他们目前先专注在封闭的基準测量进行比较,因为这样才是进行有意义的机器学习训练系统比较,开放量测目的是用于鼓励网路模型架构和其他演算法方面的创新。

.png)

Nvidia提交了7项基準测试中的6项结果,Nvidia提到,之所以选择不提交增强学习测试,是因为测试基準是基于策略游戏Go的实作,而该游戏最初是在使用Tesla P100 GPU的伺服器上开发,在目前的形式,其含有重要的CPU元件,因此规模的扩展受到了限制。最终Nvidia放弃了增强学习基準测试。

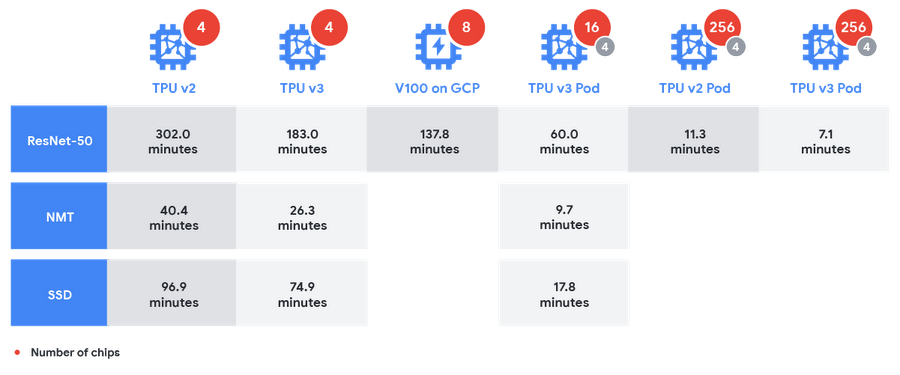

Google同样也在部落格发布了其在MLPerf上的结果,并宣称其平台最容易进行机器学习训练的扩展,并且以晶片相比,其TPU拥有19%的效能优势。Google提到,在多个MLPerf测试的竞争效能中,证明TPU(Tensor Processing Units)和TPU Pods是适合大规模训练机器学习模型的系统。

Google比较了自家1/64th TPU v3 Pod与Nvidia的DGX-2机器的绝对训练时间,其运行标準的图像分类网路ResNet-50,TPU v3 Pod共花了60分钟,而DGX-2则花了73.9分钟。DGX-2包含16个V100 GPU,而1/64th TPU v3 Pod拥有用于训练的16 TPU v3晶片与4个用于评估的TPU v2晶片。

免责声明:本文由用户上传,如有侵权请联系删除!

猜你喜欢

- 吃凤梨上火还是降火(cf雷神好还是黑龙好)

- 售楼小姐挣钱吗(真赚钱售楼小姐的一个月工资多少)

- 机动战士高达OOV(审判者纳德雷高达)

- 儿子结婚邀请函简短大气(儿子结婚邀请函简介介绍)

- 小鱼儿与花无缺林志颖版本(小鱼儿与花无缺林志颖版的现在怎么看不了了)

- msduo记忆棒(MSD记忆棒是什么东西啊)

- 巴西最重要的矿产资源(巴西最大的铁矿山是.","titletext":"巴西最大的铁矿山是.)

- 药水哥的直播在哪里看(药水哥在哪直播简介介绍)

- 我想要军装下的绕指柔得全部番外可不可以给我一份呢(我邮箱xinya12@sina.com)

- 爸爸见义勇为的作文(结尾处感想100字怎么写)

- 战鼓电影结局是什么(战鼓这部影片讲的是什么)

- start(king fx和shinee一起来的是哪期)

最新文章

- 个性标签写什么好8个字(个性标签8个字简介介绍)

- 贴吧和i吧有什么区别(贴吧和i吧有什么区别)

- 东北话得细小是什么意思(东北话小得得是啥意思)

- 太姥山旅游最新攻略一日游(太姥山旅游线路)

- 12月有什么好电影上映(12月上映好看的电影)

- 妒海主题曲百度云(泰剧妒海的主题曲和片尾mp3格式的谁有谢谢)

- 元奎在好莱坞拍过多少电影(指导过多少电影 都叫什么)

- 怎么关闭wps删除提示(wps屏幕提醒怎么关闭简介介绍)

- 4399弹弹堂vip折扣券(4399弹弹堂怎么刷点券啊)

- 企业天猫入驻条件及费用(天猫入驻条件及费用简介介绍)

- 尹相杰母亲是马玉涛吗(尹相杰母亲是马玉涛吗)

- 冬至应该吃什么食物(冬至应该吃什么食物)

- nokia6600复刻版本(NOKIA6630~~~)

- 新年快乐日语怎么说(新年快乐日语怎么说)

- 工作交接清单怎样写,格式是怎样的(工作交接清单怎样写格式是怎样的简介介绍)

- 为什么我的梦幻诛仙人物快捷键用不出来(求高手解答 我换了很多台机子了)

- 三星note3开不了机(三星note1手机为什么开不了机)

- 迅雷种子怎么提取(前缀是什么)

- poison(ivy 什么意思)

- 魔法卡片掉卡规则(魔法卡片中怎么没有变闪卡的卡友)

- 眼部结构简图(眼部结构简介介绍)

- 武汉外高国际部学费(武汉外高出国)

- 湖南台为什么叫马桶(湖南台为什么叫芒果台)

- 公元前10000年是什么年(公元前10000年)