Google在AI平台推出模型解释功能说明资料特徵与预测结果的关係

Google Cloud

Google宣布释出Explainable AI,来提高人工智慧的可解释性,让开发人员可以了解机器学习模型获得预测结果的原因。Explainable AI提供了工具以及框架,供用户部署可解释以及包容性机器学习模型,目前这项功能已经在AutoML表格和Cloud AI平台提供,用户还可结合模型分析工具What-If工具更全面了解模型行为。

机器学习可用来辨识大量资料点之间的複杂关联,儘管以这样的方式,开发者可以让人工智慧模型达到极高的精确度,但是当开发者检视模型结构或是权重的时候,通常无法了解有关于模型行为的资讯,Google提到,也因爲如此,对于部分需要有高度确定性要求的产业,在学习模型无法被解释之前,难以实际应用人工智慧机器技术。

因此Google现在宣布在云端人工智慧服务,推出人工智慧可解释性功能,该功能会量化每个资料因素对于机器学习模型输出的贡献,让用户能够利用这些讯息,进一步改进模型,或是与模型的使用者共享有用的分析资讯。

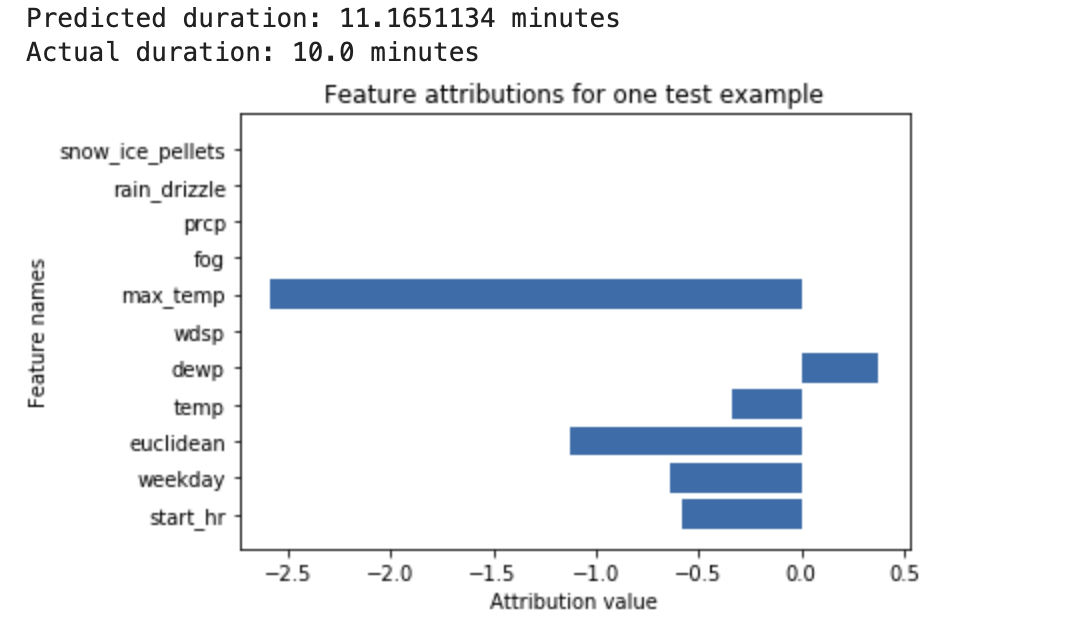

Google在人工智慧平台加入了特徵贡献(Feature Attribution)功能,让开发者能够理解用于分类(Classification)以及回归(Regression)任务的模型输出,特徵贡献会显示每个特徵对每个实例预测的贡献多寡,可用于表格资料以及图像资料。

以表格资料为例,当要以天气资料和过去骑乘脚踏车资料训练深度神经网路,当用户要求模型预测在特定天气骑士骑车分钟数,则模型输出预估自行车骑乘的持续时间,当用户要求解释预测结果,用户除了会得到预测的骑车时间,还会得到每个特徵的贡献分数(下图),贡献分数显示各因素对于预测值变化的影响程度。

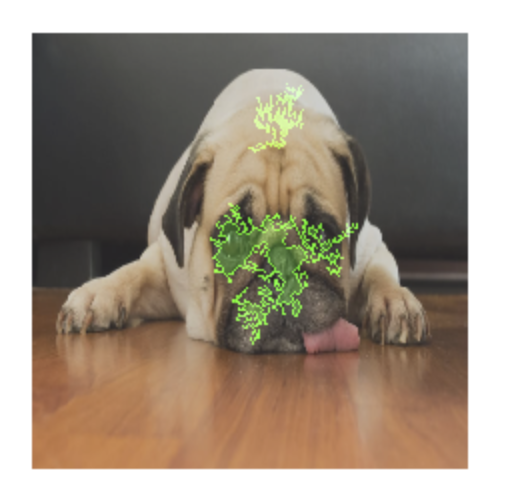

在训练图像方面,当开发者要训练一个能判断图像内动物是猫还是狗的模型,在用户要求解释时,用户会取得一个叠加的图层(下图),上面会显示哪些画素对于预测结果贡献最大。只要用户要求人工智慧平台做出解释请求时,系统便会解释资料中每个特徵贡献影响结果的组成,开发者可以使用这个讯息,来验证模型是否符合预期,并辨识出模型的偏差,获得改进模型和训练资料的想法。

不过,Google也提到,目前所有的解释方法都有其限制,Explainable AI能够反映出模型从资料找出模式的方法,但是却无法揭露资料样本、总体和应用程式之间的基础关係,目前Google会以维持其限制性透明的前提,提供直觉有用的解释方法。

免责声明:本文由用户上传,如有侵权请联系删除!

猜你喜欢

- 吃凤梨上火还是降火(cf雷神好还是黑龙好)

- 售楼小姐挣钱吗(真赚钱售楼小姐的一个月工资多少)

- 机动战士高达OOV(审判者纳德雷高达)

- 儿子结婚邀请函简短大气(儿子结婚邀请函简介介绍)

- 小鱼儿与花无缺林志颖版本(小鱼儿与花无缺林志颖版的现在怎么看不了了)

- msduo记忆棒(MSD记忆棒是什么东西啊)

- 巴西最重要的矿产资源(巴西最大的铁矿山是.","titletext":"巴西最大的铁矿山是.)

- 药水哥的直播在哪里看(药水哥在哪直播简介介绍)

- 我想要军装下的绕指柔得全部番外可不可以给我一份呢(我邮箱xinya12@sina.com)

- 爸爸见义勇为的作文(结尾处感想100字怎么写)

- 战鼓电影结局是什么(战鼓这部影片讲的是什么)

- start(king fx和shinee一起来的是哪期)

最新文章

- 个性标签写什么好8个字(个性标签8个字简介介绍)

- 贴吧和i吧有什么区别(贴吧和i吧有什么区别)

- 东北话得细小是什么意思(东北话小得得是啥意思)

- 太姥山旅游最新攻略一日游(太姥山旅游线路)

- 12月有什么好电影上映(12月上映好看的电影)

- 妒海主题曲百度云(泰剧妒海的主题曲和片尾mp3格式的谁有谢谢)

- 元奎在好莱坞拍过多少电影(指导过多少电影 都叫什么)

- 怎么关闭wps删除提示(wps屏幕提醒怎么关闭简介介绍)

- 4399弹弹堂vip折扣券(4399弹弹堂怎么刷点券啊)

- 企业天猫入驻条件及费用(天猫入驻条件及费用简介介绍)

- 尹相杰母亲是马玉涛吗(尹相杰母亲是马玉涛吗)

- 冬至应该吃什么食物(冬至应该吃什么食物)

- nokia6600复刻版本(NOKIA6630~~~)

- 新年快乐日语怎么说(新年快乐日语怎么说)

- 工作交接清单怎样写,格式是怎样的(工作交接清单怎样写格式是怎样的简介介绍)

- 为什么我的梦幻诛仙人物快捷键用不出来(求高手解答 我换了很多台机子了)

- 三星note3开不了机(三星note1手机为什么开不了机)

- 迅雷种子怎么提取(前缀是什么)

- poison(ivy 什么意思)

- 魔法卡片掉卡规则(魔法卡片中怎么没有变闪卡的卡友)

- 眼部结构简图(眼部结构简介介绍)

- 武汉外高国际部学费(武汉外高出国)

- 湖南台为什么叫马桶(湖南台为什么叫芒果台)

- 公元前10000年是什么年(公元前10000年)